近日,我院金一团队与腾讯微信团队合作,提出了一种基于多模态大模型的数据增强训练框架HQ-CLIP,开源了多达14亿样本量的高质量、多粒度图文数据库,成功训练了同等数据量级性能业界领先的CLIP模型(Contrastive Language-Image Pre-Training, 简称CLIP)。

相关研究成果以“HQ-CLIP: Leveraging Large Vision-Language Models to Create High-Quality Image-Text Datasets and CLIP Models”为题发表于CCF-A人工智能顶会ICCV 2025。该结果对基于CLIP的多模态大模型训练具有重要的参考价值。

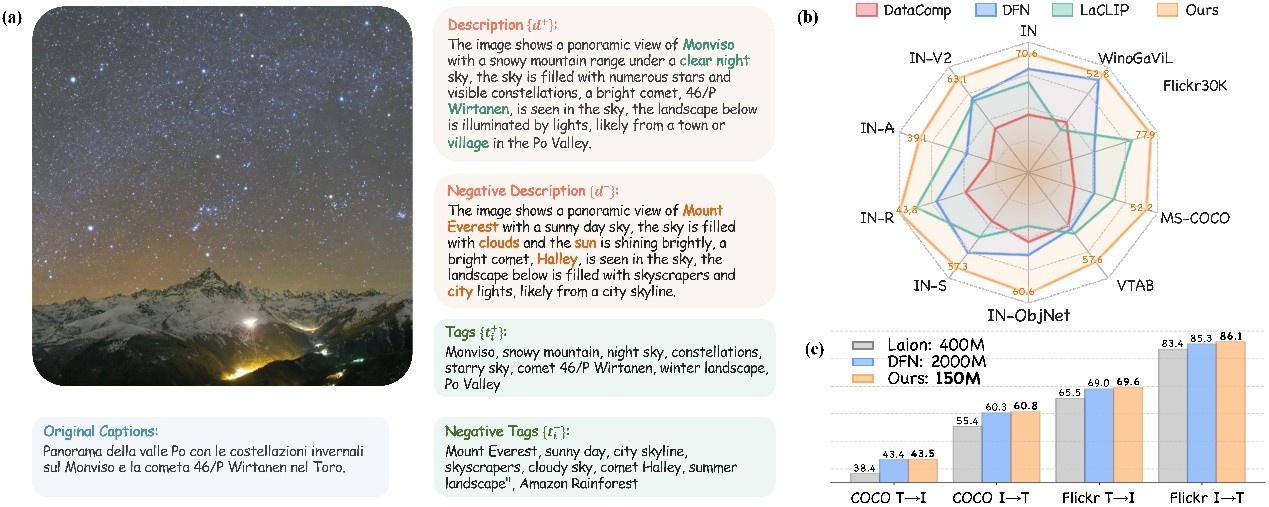

图1. HQ-CLIP具有多粒度、双向文本描述,在多个评测基准上取得领先性能

CLIP是一个由OpenAI提出的基于大量图文对进行训练的神经网络,是多模态大模型研究的基石。它可以通过自然语言指令,根据给定图像预测最相关的文本片段,而无需直接针对任务进行优化,表现出类似于 GPT的零样本识别能力。然而,CLIP训练高度依赖从互联网爬取的数以亿计的图文数据,而这类数据普遍具有极高的信噪比和图文分布不对齐的致命缺点。现有研究多利用多模态大模型或大语言模型进行图像标题重写来补充标题细节,然而,其要么忽视了图文间的跨模态关联性,要么采用了过于复杂的流程从而导致过高的计算复杂度。

基于此,中国科大团队开发了基于多模态大模型的数据增强训练框架HQ-CLIP,利用视觉语言大模型构建高质量图文数据集和CLIP模型。首先,基于一批专家标注的种子样例集,驱动GPT-4o创建了一批一万样本量的图像-标题对;其次,利用这批高质量数据对三个开源多模态大模型(Qwen2VL、InternLM-XComposer2、LLaVA-Next)监督微调,并优中选优,获取了具有高度指令遵循能力和标题描述能力的微调模型;最后,团队在大规模GPU集群上部署微调后模型执行推理,创建了高达14亿的完整图文数据集。

该数据集中的每一个样本都同时包括了正面/负面描述和长文本/短标签,此类双向多粒度文本不仅提升了数据集质量,也为CLIP训练方法带来了新的挑战。为此,团队进一步提出了一个新的CLIP训练方法,在传统的CLIP训练基础上,进一步拓展了负样本鉴别损失和短标签分类监督充分利用数据信息,提升了CLIP模型的细粒度识别能力和特征可鉴别性。结合这一高质量数据集和新的训练方法,团队成功训练了在同等数据规模上具备业界领先能力的CLIP模型,在38个评测指标上的平均性能超越了OpenAI团队的CLIP模型和Apple团队的DFN模型,证明了该技术的潜在应用价值。

我院博士生魏智翔与腾讯高级研究员王光庭为论文第一作者,金一副教授和陈怀安特任副研究员为论文的共同通讯作者。近年来,金一团队面向国家重大战略需求,围绕成像探测与智能感知开展深入研究,在人工智能、科学成像、仪器智能体等方向,取得丰硕成果领域深耕多年,在CVPR、ICCV、NeurIPS、ICLR等人工智能国际顶会上发表多篇文章,提出视觉基础模型引导的暗光图像增强(CVPR2025)、基于积分快速傅里叶颜色恒定性的图像处理模型(CVPR2025)、基于视觉基础模型的领域泛化分割方法(CVPR2024)等多项成果并得到广泛关注。本文第一作者魏智翔博士在CVPR 2024上发表的“Stronger, Fewer, & Superior: Harnessing Vision Foundation Models for Domain Generalized Semantic Segmentation”被国际人工智能顶会CVPR2025(BRAVO challenge)挑战赛官方委员会评价为“令人振奋的工作(amazing work)”, 并将其作为该挑战赛的基准方法。

论文链接:https://zxwei.site/hqclip/

(精密机械与精密仪器系)